Grok-1是什么?

Grok-1是马斯克旗下AI公司xAI发布的开源AI大模型,其参数量达到了3140亿,远超OpenAI GPT-3.5的1750亿。这是迄今参数量最大的开源大语言模型,遵照Apache 2.0协议开放模型权重和架构。

Grok-1是一个混合专家(Mixture-of-Experts,MOE)大模型,这种MOE架构重点在于提高大模型的训练和推理效率,形象地理解,MOE就像把各个领域的“专家”集合到了一起,遇到任务派发给不同领域的专家,最后汇总结论,提升效率。决定每个专家做什么的是被称为“门控网络”的机制。

Grok-1模型的公开发布,为研究人员和开发者提供了一个新的大型语言模型资源。

Grok-1的主要特性

xAI还特别强调了Grok-1的几大特性:

- 首先,Grok-1是一个未针对特定任务进行微调的基础模型,它基于大量文本数据训练而成;

- 其次,作为一款基于混合专家技术构建的大语言模型,Grok-1拥有3140亿参数,在处理每个token时有25%的权重处于活跃状态;

- 最后,Grok-1是xAI团队使用JAX和Rust编程语言自定义训练栈从零开始训练的成果,训练完成于2023年10月。

Grok-1的技术参数

基础信息:

模型大小:3140亿参数,其中混合了8名专家(2名活跃)

活动参数:860亿

特色技术:使用旋转嵌入(Rotary Embeddings,简称#rope),而非固定位置嵌入

模型结构细节:

分词器词汇量:131,072(与GPT-4相似),即2^17

嵌入尺寸:6,144(48*128)

架构层数:64层变压器层

每层结构:包含一个解码器层,具有多头注意力块和密集块

键值大小:128

多头注意力块:

查询头数量:48

键/值(KV)头数量:8

KV大小:128

密集块(Dense Block):

加宽系数:8

隐藏层大小:32,768

每个代币从8名专家中选择2名

旋转位置嵌入:

尺寸:6,144,与模型的输入嵌入大小相同

上下文长度:8,192个标记

精度:bf16

如何使用Grok-1?

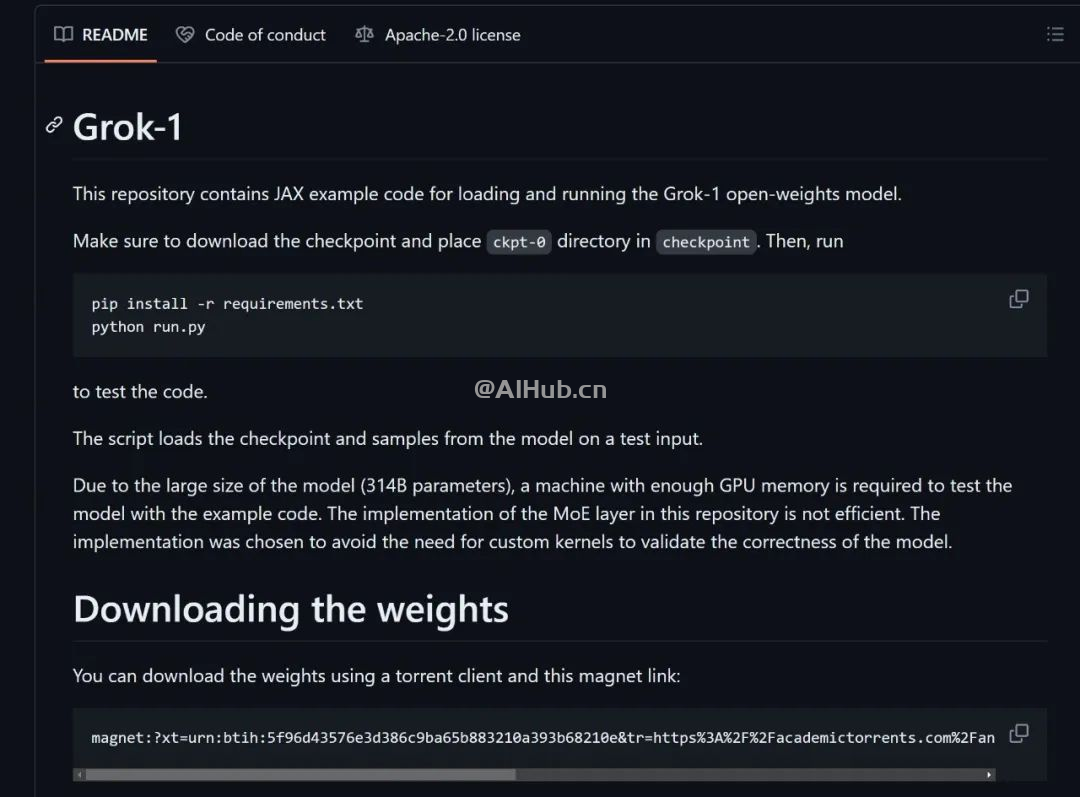

xAI已经将Grok-1的权重和架构在GitHub上开源。

GitHub地址:https://github.com/xai-org/grok-1