Octopus v2是什么?

Octopus v2是由斯坦福大学研究团队最近推出的可在设备上运行的端侧AI模型,引起了开发者社区的广泛关注,一夜之间下载量超过了2000次。Octopus v2是一个拥有20亿参数的模型,能够在智能手机、汽车、个人电脑等设备上运行。它在准确性和延迟方面超越了GPT-4,且将上下文长度减少了95%。与基于RAG的Llama7B模型相比,Octopus v2的速度快了36倍。

Octopus v2的功能特性

- 高准确性和低延迟:通过优化模型结构和参数,Octopus v2实现了在设备上运行时的高准确性和低延迟性能。

- 大幅减少上下文长度:相较于传统模型,Octopus v2在模型推断过程中将上下文长度减少了超过95%。

- 适用于边缘设备:该模型的设计考虑到了边缘设备的性能和资源限制,使其能够在智能手机、汽车、VR头盔和个人电脑等设备上高效运行。

- 保护隐私和降低成本:相对于依赖云计算的大型语言模型,Octopus v2提供了一种在保护用户隐私和降低推理成本方面的优势。

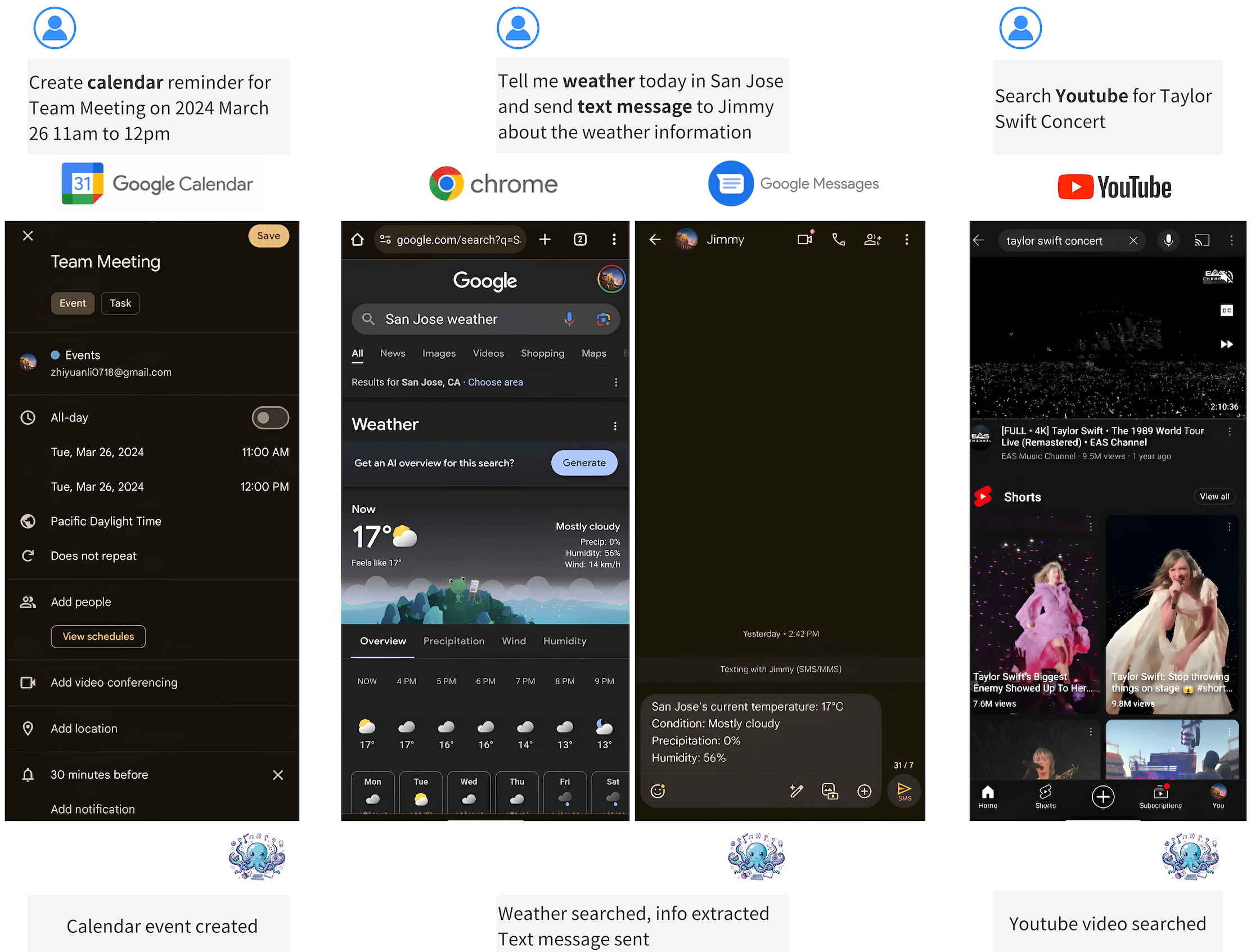

Octopus v2的应用场景

- 移动设备应用:在智能手机上运行复杂的语言处理任务,提供即时反馈和交互。

- 汽车内置系统:在汽车的娱乐和信息系统中,提供更智能的语音交互功能。

- 个人电脑软件:为个人电脑上的软件应用提供高效的语言处理能力,包括文本分析和自然语言理解。

- 智能家居设备:在智能家居设备中,利用语言模型提高设备的智能交互和自动化水平。

如何使用Octopus v2?

Octopus v2的论文和模型已提供下载。

论文地址:https://arxiv.org/abs/2404.01744

模型主页:https://huggingface.co/NexaAIDev/Octopus-v2

Octopus v2的推出标志着设备端AI智能体时代的到来,为开发者和用户提供了前所未有的AI应用体验和可能性。