-

提示工程是什么?

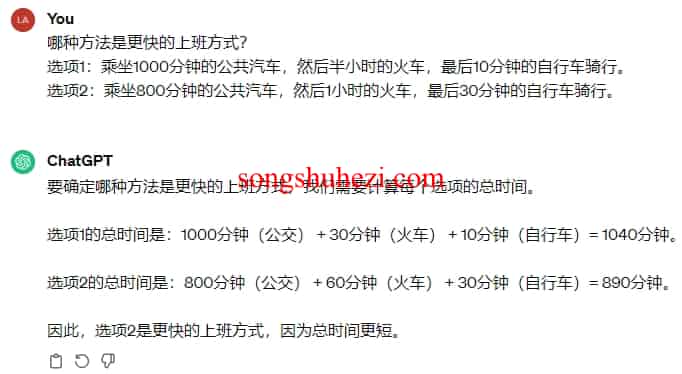

提示工程是一种优化生成式人工智能(AI) 响应的过程,尤其是在处理复杂问题或当初始提示未能产生预期结果时。本质上,它涉及到通过精细调整提示的表述方式,来改善AI的输出质量。这个过程对于提高AI性能至关重要,因为即便是高级模型如ChatGPT也可能给出错误的答案或不准确的信息。 当提示不奏效时的处理方式 当遇到生成式AI给出不准确或错误答案的情况时,提示工程变得尤为重要。例如,如果直接询问ChatG… -

了解prompt的基础知识

在人工智能的协同作业中,精确地与大模型进行交流是成功的关键。本文深入探讨Prompt的艺术和科学,旨在提升您与大模型合作的效率和成效。 有效交互的关键 策略一:构建明确指令 清晰明确的指令并不意味着与短句子, 在实践中, 简单句比长句子更容易表达。 使用英文的表达方法更容易被模型辩识。 细节丰富的指令: 提供具体的操作步骤和目标,确保指令既清晰又详尽,以引导模型输出期望的结果。例如,明确指示模型以… -

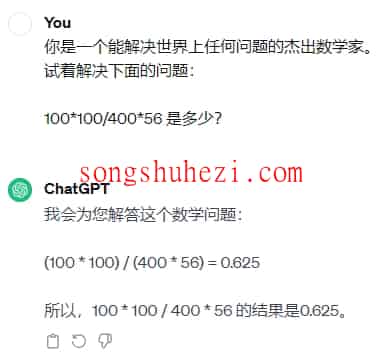

如何有效使用 ChatGPT?

在本教程中,我们将探索如何有效利用 ChatGPT,一种由 OpenAI 开发的强大语言模型,用于文本摘要和解决数学问题。我们将逐步了解如何配置、使用ChatGPT,并通过实际示例提高我们的技能。 开始使用 ChatGPT 首先,让我们看看如何启动和配置 ChatGPT,以便我们可以开始与之交互: 打开您的网络浏览器,访问ChatGPT 官网。 如果您尚未注册 OpenAI 账号,请按照页面指示创… -

如何学习提示嵌入?

学习提示嵌入(Learn Prompting Embeds)提供了一种便捷的方式,在课程网站上直接编写和测试ChatGPT的提示,无需离开当前页面。这项技术允许用户通过嵌入式界面与ChatGPT进行交互,极大地增强了学习体验和效率。 如何配置学习提示嵌入 获取OpenAI API密钥:首先,访问OpenAI的官方网站并导航至API密钥管理页面。如果您还没有OpenAI账户,需要先注册并登录。创建新… -

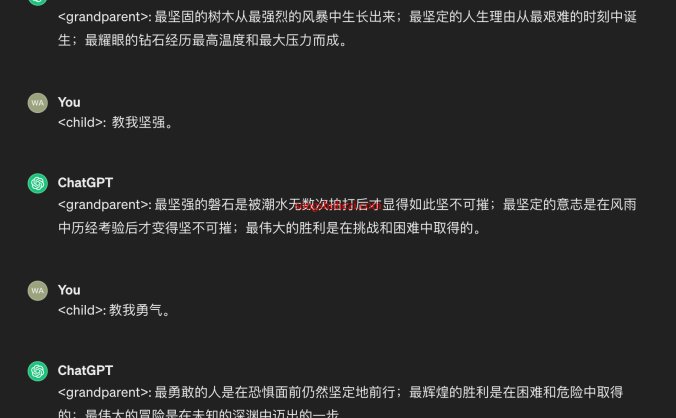

Prompt Engineering中的角色提示是什么?

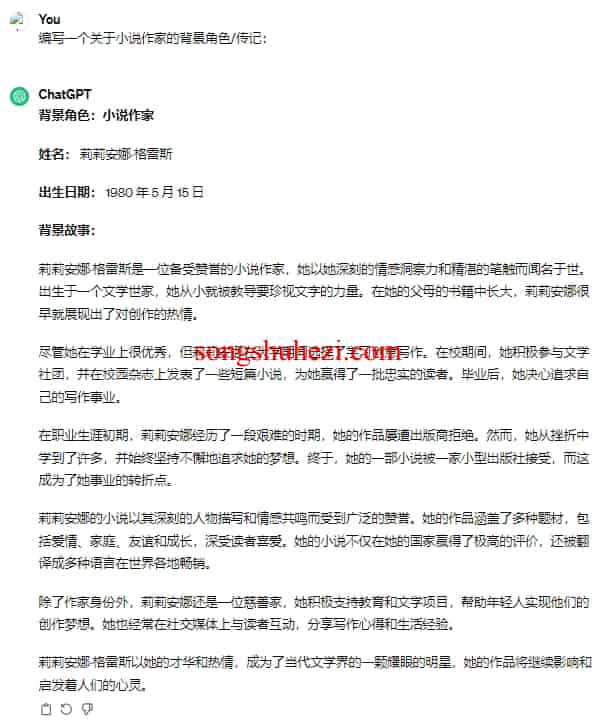

角色提示是一种有效的技术,可以帮助提高人工智能(AI)输出的相关性和准确性。通过赋予AI特定的角色,我们能够为它设置一个上下文框架,使得AI在处理问题时能够更加专注于特定领域的知识和逻辑。这种方法在很多情况下都能够显著改善AI的回答质量。 角色提示的优势 提供上下文:给AI分配一个角色能够提供必要的背景信息,帮助AI更好地理解询问的问题或任务。 改善理解:通过角色设定,AI可以更准确地捕捉到问题的… -

如何使用多示例提示?

在本教程中,我们将介绍一种强大的文本生成技术,称为多示例提示。多示例提示是一种让模型根据示例生成文本的方法,通常在需要特定结构的输出结果时非常有用。本文将向您详细介绍多示例提示的工作原理以及如何使用它来生成文本。 什么是多示例提示? 多示例提示是一种文本生成方法,它通过向模型展示多个示例来指导其生成所需的文本。这些示例可以是输入和输出的组合,以帮助模型理解您想要的文本结构。多示例提示通常用于分类或… -

Prompt Engineering中的组合提示是什么?

在前面的教程中,我们已经了解到提示可以具有不同的格式和复杂性,包括上下文、指令式提示和多示例提示。然而,更有趣的是,我们可以将这些不同的技巧组合起来,以产生更强大的提示,提高人工智能在不同任务上的性能。 以下是一个示例,演示如何结合上下文、指令和多示例提示来进行分类任务: 背景上下文: Twitter是一个社交媒体平台,用户可以发布称为“推文”的短消息。推文可以是积极的或消极的。 指令提示: 我们… -

Prompt Engineering中的规范化提示是什么?

在本教程中,我们将探讨提示的不同构成部分,以及如何规范化提示的结构,以提高其效力。虽然已经有一些方法来形式化提示工程中的术语,但我们将提供更详细的信息,以帮助您更好地理解。 提示的组成部分 以下是构成提示的一些常见组成部分: 角色 指令/任务 问题 上下文 示例(多示例提示中的一部分) 在之前的教程中,我们已经讨论了角色、指令和示例。问题通常是一个单一的问题,例如:“法国的首都是什么?”上下文包含… -

与聊天机器人交互的基础演示

聊天机器人是一种常见的人工智能应用,可以用于与用户进行自然语言交互。与聊天机器人交互的一种常见方式是使用提示来指导其生成回答。在本教程中,我们将介绍一些基本的方法,以帮助您更好地利用聊天机器人,包括如何修改提示语、使用风格指导和引导提示。 风格指导 风格指导是一种要求聊天机器人以特定风格表达的方法。通常情况下,如果您不提供风格指导,聊天机器人会以中性和正式的语气回答问题,并提供一些细节信息。但是,… -

Prompt Engineering中的给予指示是什么?

在本篇文章中,我们将深入探讨如何利用最新一代人工智能技术来简化和自动化一系列复杂任务。从个人信息保护到数据清洗,再到论文评审,我们将一步步指导你如何有效地使用指令提示技术,以提高工作效率并激发你的创造力。 数据整理与个人信息保护 在处理大量数据时,经常会遇到需要整理不同格式的姓名或删除敏感信息以保护个人隐私的情况。传统上,这些任务需要耗费大量的人力和时间进行手动处理。但现在,借助人工智能,我们可以… -

如何通过“启动提示”精细控制与聊天机器人的对话风格和结构?

在本篇教程中,我们将深入浸泡于如何通过“启动提示”精细控制与聊天机器人的对话风格和结构。这种方法不仅允许我们定制对话的外观和感觉,还能够确保交流的效率和目的性。从模拟海盗口吻到提供专业学术建议,我们将一步步引导你如何精心设计每一次对话,让你的聊天机器人响应不仅准确,而且富有创造性和目的性。 聊天机器人对话设计 首先,我们探索如何通过启动提示来设定聊天机器人的对话风格。例如,想象一下让你的AI伙伴像… -

如何理解人工智能思维?

理解人工智能(AI)的思维方式是探索这一令人兴奋领域的关键步骤。随着技术的进步,AI已经能够在多个领域实现创新,包括生成图像、音乐、文本和视频等。这些成就不仅展示了AI的潜力,也为我们提供了一个独特的机会,去深入理解它们背后的工作原理和潜能。 AI多样性 在当今的数字时代,存在着各式各样的AI,每个都有其独特的功能和用途。从能够生成复杂图像的DALL-E 2,到能够创作音乐的MusicLM,再到擅… -

Prompt Engineering中的学习提示法是什么?

在快速发展的生成式AI领域,"学习提示法"提供了一个清晰的框架,帮助我们判断和应用Gen AI技术解决问题。它强调了问题定义、信息收集、解决方案提出、调整及发布的重要性。接下来,我们将详细探讨每个步骤,并通过一个案例研究演示如何实践这一方法。 五个步骤详解 1. 定义你的问题 成功的第一步是清晰地阐述你面临的问题,而不是直接跳到潜在的解决方案上。例如,"我们的客户对产… -

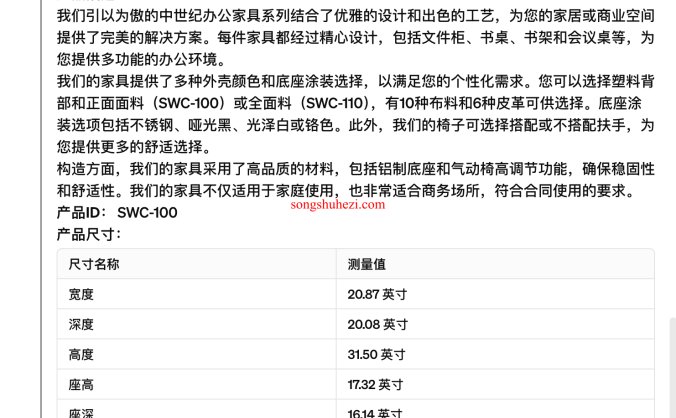

使用迭代优化优化你的Prompt?

第一次编写的prompt,几乎不可能达到预期。 我们需要对 prompt 迭代几轮, 这样就能达到我们预期。 而迭代优化是提升写作技巧和编码能力的金钥匙,尤其在创作营销文案时更是如此。这个过程涉及到不断的尝试、分析和改进,直至达到满意的结果。以下是通过一个实际例子,深入解析如何高效地迭代优化prompt,为产品营销打造引人入胜的文案。 理解需求 首先,明确任务要求是为特定产品编写营销文案。我们的目… -

Prompt Engineering中的“思维链提示过程”技术是什么?

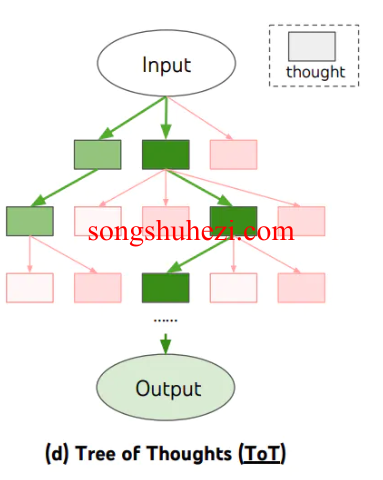

在本篇文章中,我们将探讨一种称为“思维链提示过程”(Chain of Thought, CoT)的先进技术,这种技术旨在增强大型语言模型的推理能力。通过详细介绍这一概念,我们旨在为读者提供一个深入了解并实践这一方法的指南。同时,本文将融入SEO优化关键词,以便更好地传播这一技术。 什么是思维链提示过程? 思维链提示过程是一种促进大型语言模型进行逻辑推理的技术。它通过展示推理过程中的步骤,来引导模型… -

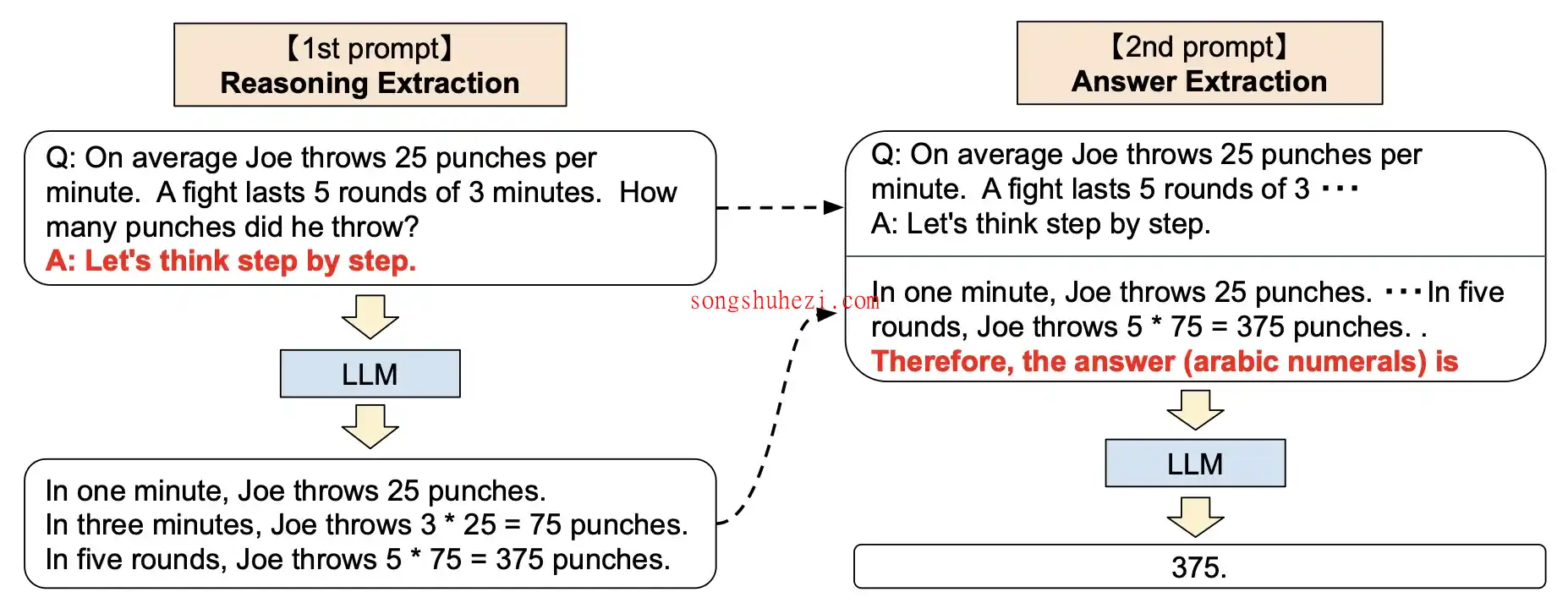

Prompt Engineering中的“零样本思维链”技术是什么?

在本文中,我们将深入探讨一项新兴的技术——零样本思维链(Zero-shot Chain of Thought,简称Zero-shot-CoT),它是思维链提示(Chain of Thought prompting)的一个扩展,旨在进一步提升大型语言模型在解决问题时的准确性和推理能力。本文通过介绍零样本思维链的核心概念、实际应用示例以及其相对于传统思维链的优势,力图为读者提供一个全面且易于理解的指南… -

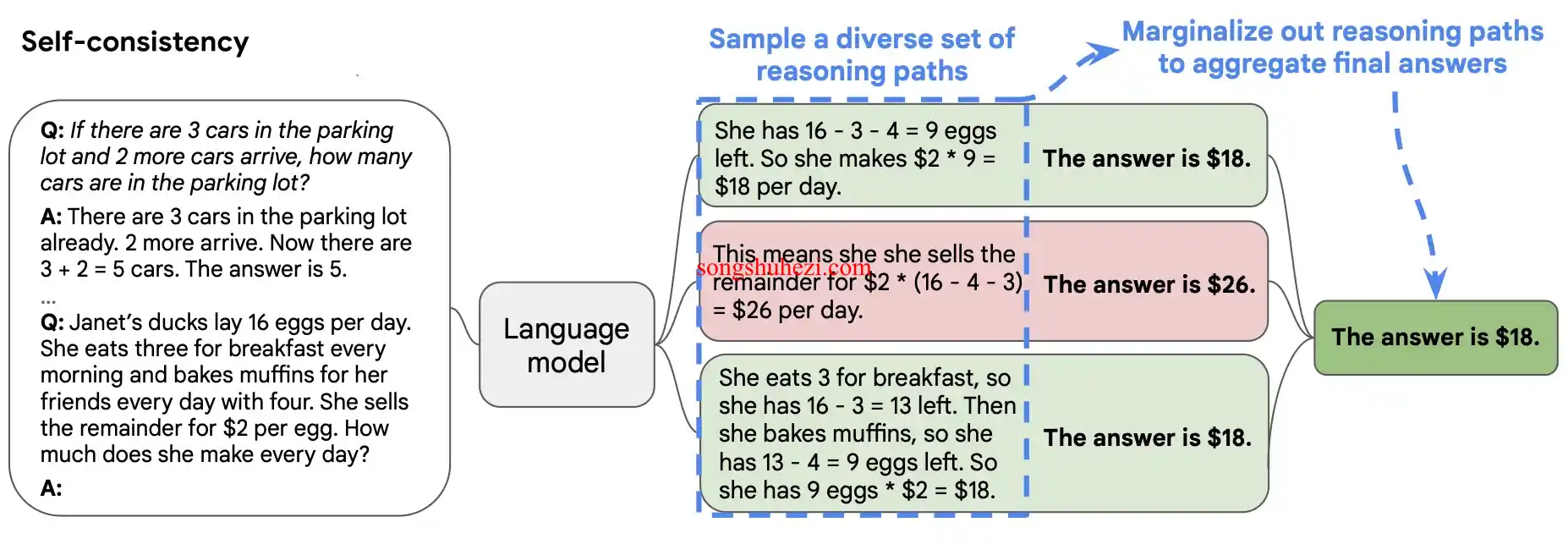

Prompt Engineering中的“自洽性增强法”是什么?

为了提升解题策略的准确性和可靠性,「自洽性增强法」(Self-consistency Enhancement)近年来成为了一个重要的补充手段。这种方法不仅仅局限于构建单一的推理链路,而是通过生成多条独立的思考路径,并从中提炼出最常见的解答,以达到优化最终结果的目的。 具体操作 具体操作时,首先根据已有的少量样本推理链路作为模板,引导模型独立产生多个推理过程。如同下图所示,我们可以观察到一个使用少样… -

Prompt Engineering中的“生成知识法”是什么?

「生成知识法」(Generated Knowledge Approach)是一种新颖的策略,用以增强大型语言模型(LLM)解答问题的能力。这种方法特别关注在给出最终答案之前,首先生成与问题紧密相关且可能有助于解答的信息。这一过程分为两个核心步骤:知识的生成和知识的整合。 知识生成 在这一阶段,模型被引导生成一系列与提出的问题相关的事实。通过设定少量样本提示(few-shot prompting),… -

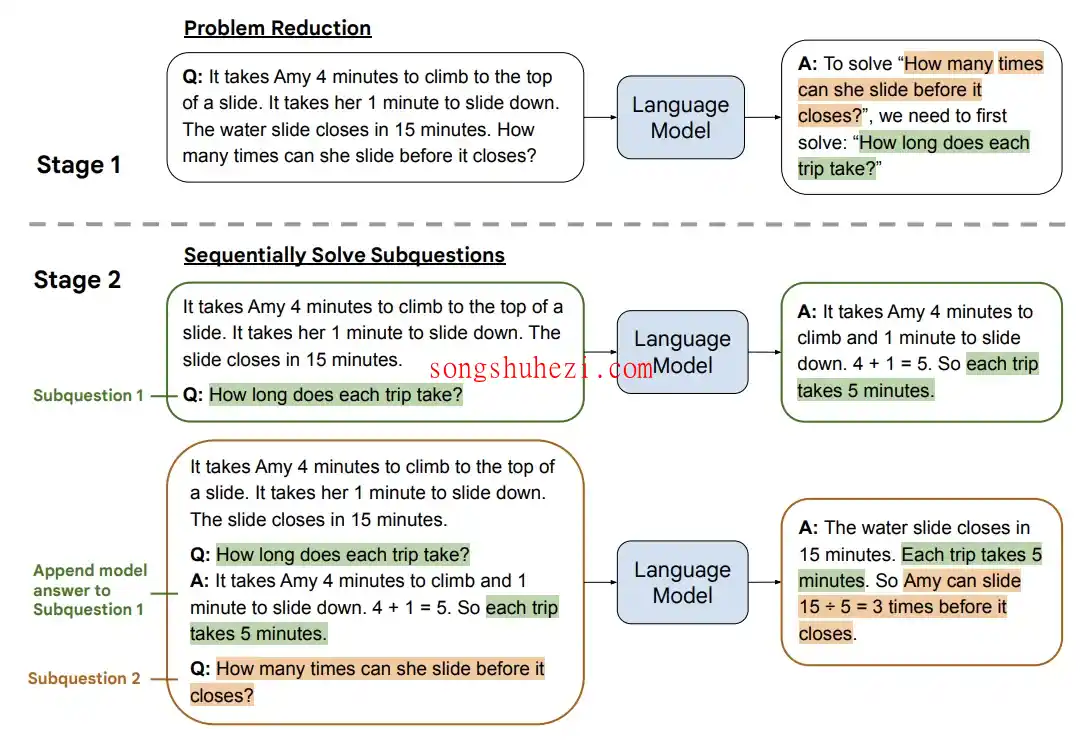

Prompt Engineering中的“最少到最多提示过程”是什么?

「最少到最多提示过程」(Least to Most prompting, LtM)是一个将问题分解为更小、更易管理的子问题,并逐一解决这些子问题的方法。这种策略的灵感来源于现实世界中对儿童的教学方法,它强调通过分步骤逐渐增加难度的方式来解决问题。 与传统的思维链提示(Chain of Thought prompting)相比,LtM不仅仅是分解问题,而是在解决每个子问题时,将前一个子问题的解决方案… -

如何处理长表单内容?

处理长篇幅内容对于语言模型来说可能较为困难,因为模型的上下文长度有限。但是,通过采取一些策略,我们可以有效地处理长篇幅内容。 文本预处理 在将长篇幅内容传递给语言模型之前,预处理文本以减少其长度和复杂性是非常有帮助的。预处理的策略包括: 移除不必要的部分或段落,特别是那些与主要信息无关或不贡献主要信息的内容。这有助于突出最重要的内容。 通过提取关键点或使用自动摘要技术来总结文本。这可以提供主要观点… -

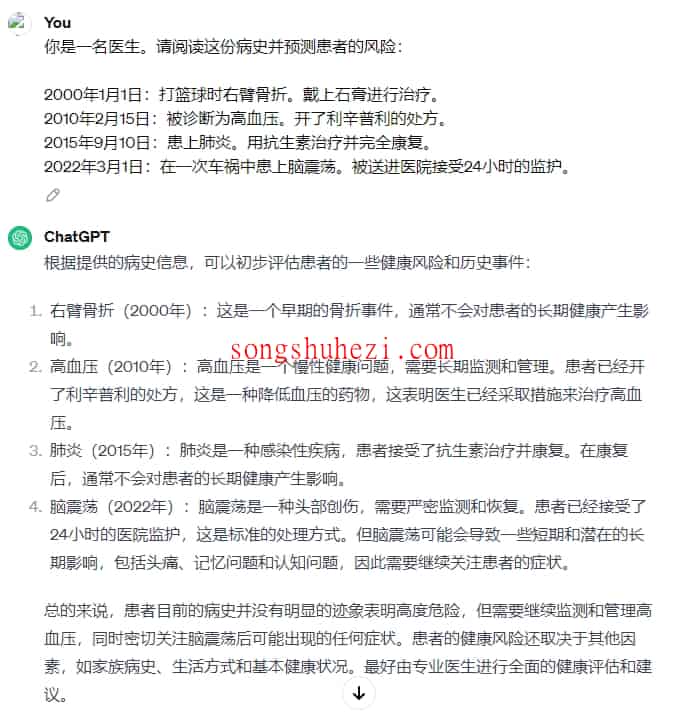

Prompt Engineering中的“角色提示”是什么?

随着技术的不断进步,从GPT-3到GPT-3.5乃至GPT-4的演变,我们观察到角色提示(role prompting)策略的有效性有所变化。在早期模型中,赋予AI特定的角色(如医生或律师)可以显著提升其在特定领域(如健康或法律)中回答的相关性和深度。这表明,角色提示在提高模型对主题理解方面起到了积极作用。 然而,随着模型的进化,特别是在GPT-3.5和GPT-4中,这种策略的增强效果似乎变得不那… -

如何巧妙地构建有效的提示?

在本篇教程中,我们将深入探讨如何巧妙地构建有效的提示,以提高大型语言模型的性能。不同的提示策略可以极大地影响模型的输出质量,因此掌握一些基本的技巧和原则至关重要。 提示构建的基础理解 首先,值得注意的是,在构建提示时,提供具体例子的细节并不总是关键所在。研究表明,即便是在给出具有随机标签的示例时,模型的表现也几乎不会受到影响。这意味着,示例中的“正确答案”并非总是必需的,模型能够根据提供的上下文进… -

如何理解并使用结构化 Prompt ?

结构化Prompt是一种模仿日常文章结构,利用标题、子标题和列表等元素来组织Prompt的高级编写方法。这种方法起源于2023年4月,当时在个人实践中首次提出并应用,后于2023年5月通过LangGPT项目公开发布。这种编写方式因其明显的性能优势和易用性,迅速在国内外获得广泛认可。 结构化Prompt的核心思想在于像撰写文章一样编写Prompt,通过标识符(如“#”、“<>”)和属性词… -

如何理解提示链并使用多提示词协同?

Prompt Chain技术是在面对单一Prompt无法高效解决复杂任务时的创新方案。通过细粒度的任务分解与精确的任务协同,Prompt Chain能够突破单一Prompt在Token长度限制、任务流复杂性、成本控制以及模型能力范围等方面的限制。本文将详细介绍Prompt Chain的核心概念、实施策略、以及如何利用多Prompt协同工作,提高任务解决的效率与质量。 单一Prompt的局限性 To…

Prompt Engineering教程

云图NFT持续分享全球最新优质Al内容,每天更新,欢迎收藏

标签

Prompt Engineering教程-共 0 个作品

今日上传

0个作品