ViewDiff是什么?

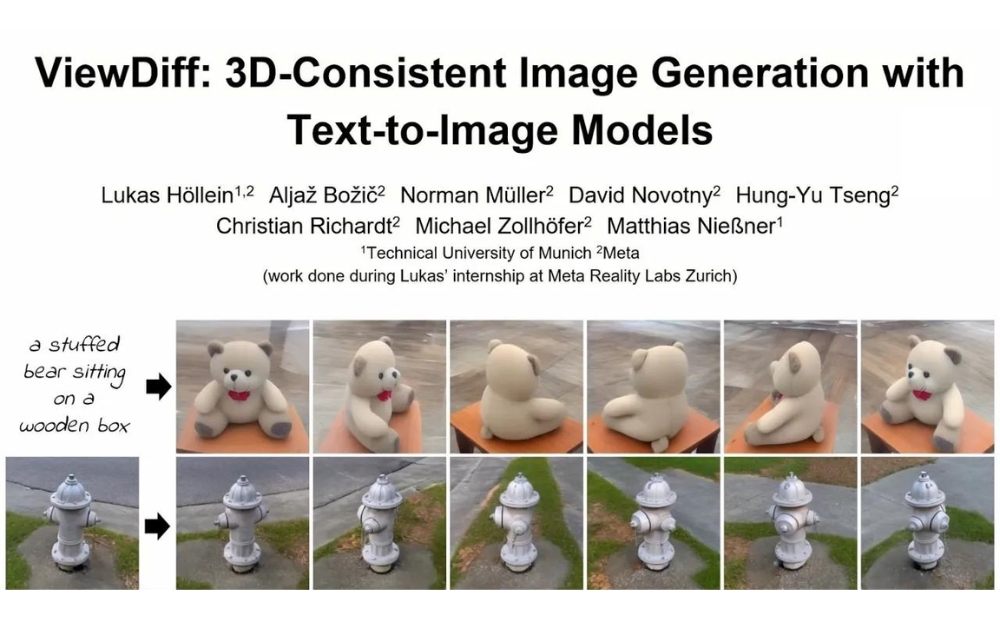

ViewDiff是一个由 Meta 与德国慕尼黑工业大学研发的创新AI模型,旨在帮助用户通过文本、图像或二者结合使用,快速生成高质量多视角3D 图像。

ViewDiff解决了传统文本生成多视角 3D 图像领域的三大难点:无法生成真实背景环境、图像质量和多样性不理想、缺乏多视角和一致性。通过引入一种创新架构,ViewDiff 采用文生成图模型作为先验知识和图像流生成器,再通过显式的 3D 建模为图像赋予一致性和多视角能力。

ViewDiff的工作原理

ViewDiff利用一种先进的文本到图像的技术来生成3D一致的图像。它结合了多个视角的图像生成和3D渲染技术,通过以下关键步骤实现其功能:

1、文本到图像的生成:ViewDiff首先接收用户输入的文本描述或单个图像作为输入。这个描述或图像概括了用户希望生成的3D对象的特征和样式。

2、多视角图像合成:使用一种自回归模型,ViewDiff能够根据输入逐步生成对象在不同视角下的图像。这个过程是迭代的,模型在每一步生成新的视角图像时,都会考虑到前一视角的信息,确保视角之间的连续性和一致性。

3、3D特征的投影:在生成多视角图像的同时,ViewDiff使用一种名为“投影层”的技术,将2D图像特征转换为3D空间中的体素网格。这个过程涉及到深度和空间位置的推算,以及特征的3D定位。

4、体素网格的集成与细化:生成的体素网格随后会在3D空间中进行集成和细化处理。这一步骤是通过一种类似于神经辐射场(NeRF)的体渲染技术完成的,它可以精确地渲染出3D特征,包括光线、阴影和反射等效果。

5、3D渲染输出:最后,ViewDiff通过3D渲染技术输出最终的图像。这些图像不仅在视觉上具有高度的一致性和连贯性,而且能够从多个角度真实地展示3D对象的细节和特征。

总的来说,ViewDiff的工作原理基于将文本描述转化为3D图像的复杂流程,涵盖了从文本解析到多视角图像生成,再到3D特征投影和细化处理,最终实现高质量的3D图像渲染。这一过程依赖于先进的AI技术和计算机视觉算法,使得从简单的文本或图像输入到复杂的3D图像输出成为可能。

ViewDiff的适用人群

- 计算机视觉研究者:对于那些专注于图像处理和3D建模的研究者,ViewDiff提供了一种新的方法来改善3D图像的生成质量。

- 游戏和娱乐行业的开发者:游戏设计师和动画制作人可以使用ViewDiff来创建更真实的3D动画和环境,提升视觉效果和用户体验。

- AR/VR开发者:在增强现实和虚拟现实应用中,ViewDiff的技术可以用于生成真实一致的3D场景和对象,增强沉浸式体验。

如何使用ViewDiff?

ViewDiff放出了论文、代码,相关资源如下:

- 项目地址:https://lukashoel.github.io/ViewDiff/

- 论文地址:https://arxiv.org/abs/2403.01807

- GitHub地址:https://github.com/facebookresearch/ViewDiff

总之,该研究的推出填补了文本生成多视角3D 图像领域的技术空白,有望为游戏开发、元宇宙等行业提供更便捷、高效的模型构建方案。该模型的推出不仅在技术层面上具有重大意义,也将为未来的3D 图像生成领域带来更多创新可能。