GPT-2模型通过在庞大的WebText数据集上进行无监督学习,展现了卓越的多任务处理能力。这种方法使得模型在多个NLP任务上取得了优异的成绩,证实了在大规模数据和高参数量的支持下,模型性能的显著提升。

尽管现有的机器学习模型在大数据和高参数量的环境下表现出色,但它们对数据分布和任务规范的轻微变化非常敏感,显示出脆弱性。我们的目标是创建一个更通用的系统,能在多任务环境中表现出色,甚至在无需标记数据和微调的情况下也能有效工作。

方法论

GPT-2采用的是单向Transformer结构,通过语言建模来进行无监督学习。它不依赖于双向结构,如BERT,而是通过一个巨大的数据集训练,这个数据集被称为WebText,包含了多种网络文本,如新闻、博客等。

训练数据集

WebText数据集由大量的互联网页面组成,通过筛选和清理,去除了重复内容,如维基百科条目,以确保数据的多样性和独特性。这使得GPT-2可以在广泛的领域中学习并展示其能力。

输入表示

GPT-2采用了字节对编码(BPE),这种方法在字符级和词级之间有效地插值,使得模型能够处理各种符号序列,并通过这种方式优化了模型的输入处理。

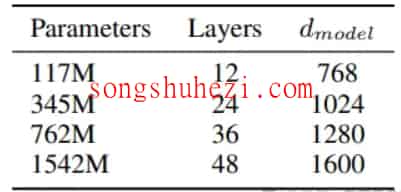

模型架构

该模型继承了GPT的设计,但进行了优化和调整,例如扩展了词典规模,并调整了层次结构和批处理大小以适应更大规模的训练。

实验与结果

GPT-2在多个NLP基准测试中表现出色,特别是在WebText数据集上进行的零样本测试中,它在多数情况下超越了其他模型。该模型的多样性和灵活性使其在未经训练的NLP任务中也能表现优异。

GPT-2通过其大规模的无监督训练,在多个领域中都展现了强大的性能和通用性。对我而言,GPT-2的最大吸引力在于它展示了机器如何利用庞大的数据集来理解和生成复杂的语言结构。我被它在理解上下文和生成连贯文本方面的能力深深吸引。尤其是在进行文本生成任务时,它能够产生流畅且逻辑连贯的段落。