MaxKB 是一款基于大语言模型的知识库问答系统,它结合了大预言模型和知识库问答系统的优势,为团队提供了快速、智能的信息检索和问答服务。传统的文档管理方式可能缺乏上下文感知能力,而MaxKB可以完全理解用户提问的上下文,为用户提供更加相关和连贯的问题。

本文将介绍如何安装和配置MaxKB,快速搭建基于大语言模型的知识库问答系统,提高团队的知识管理和共享效率。

一、安装开源 ollama

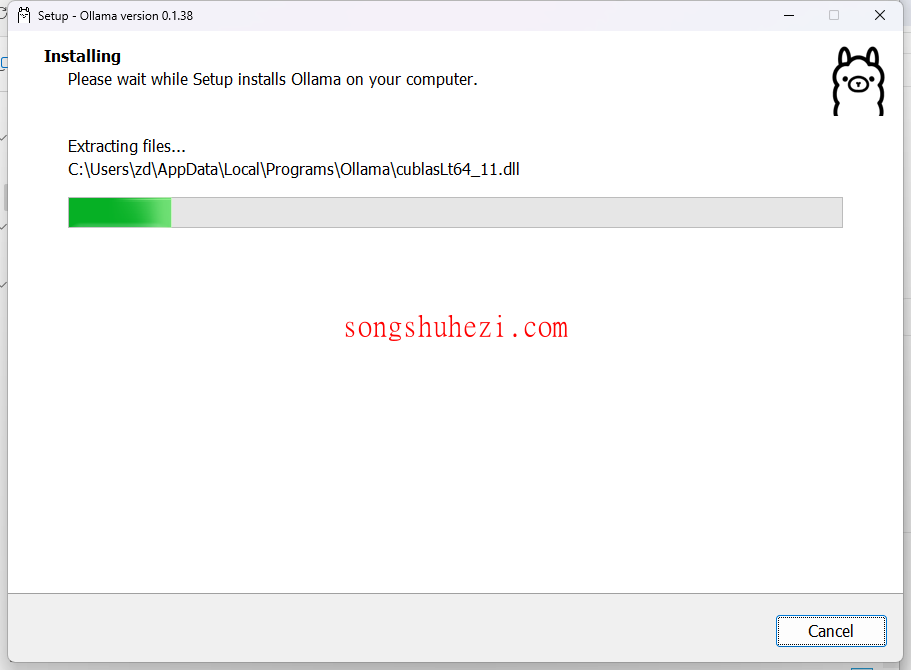

安装ollama

首先安装开源 ollama,它是一个大语言模型服务工具,可以帮助个人在本地快速运行大语言模型。

下载好对应安装包,然后点击安装ollama。

安装llama3(可跳过)

由于本教程使用的是LLaMA3中文微调模型,所以llama3可以不用安装,这里简单提一下。

使用简单命令即可启动或运行需要的模型。

复制

ollama run llama3

ollama run llama3

等待安装完成,然后试试效果,LLaMA3 对中文的处理能力确实很差。

ollama支持多种开源大语言模型,包括常见的LLaMA3和Gemma。本文使用 ollama 安装LLaMA3中文微调模型。

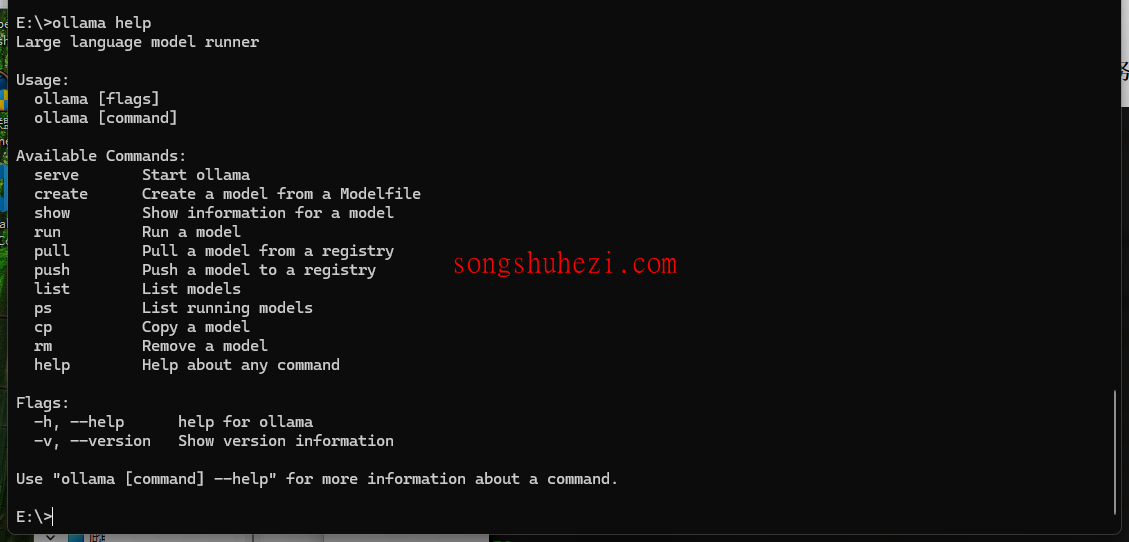

ollama 操作命令

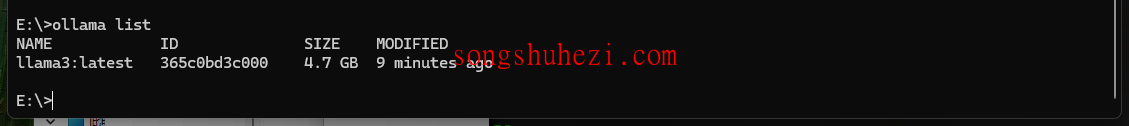

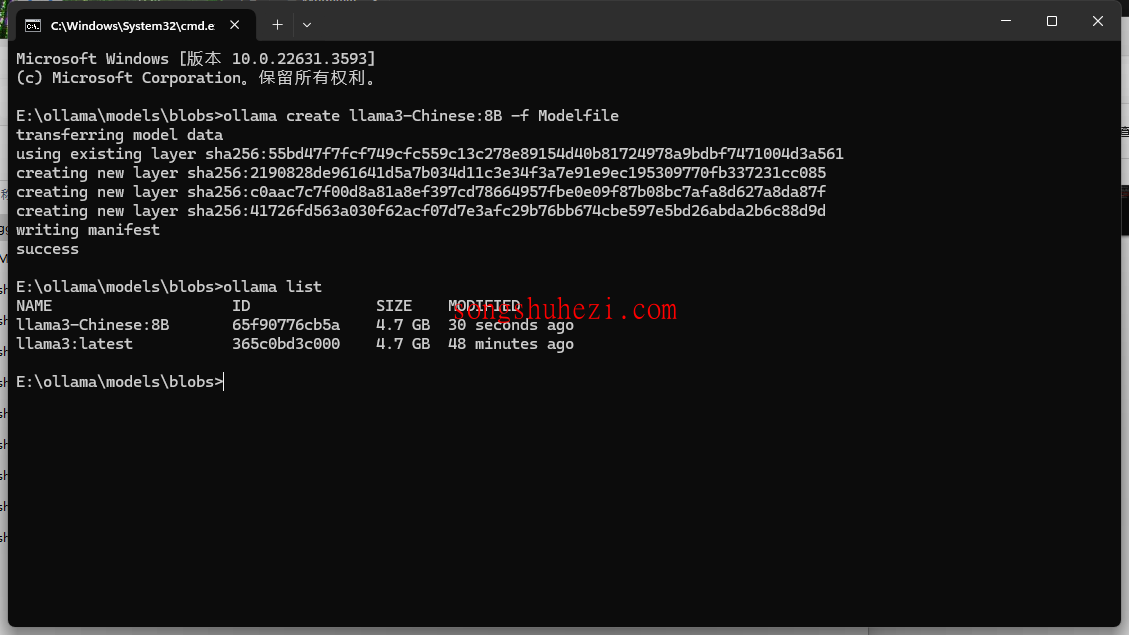

安装完成后,启动 ollama 服务,查看已安装的模型列表。

查看本地安装的模型

使用命令 ollama list 查看本地已安装的模型列表。

二、安装LLaMA3中文微调模型

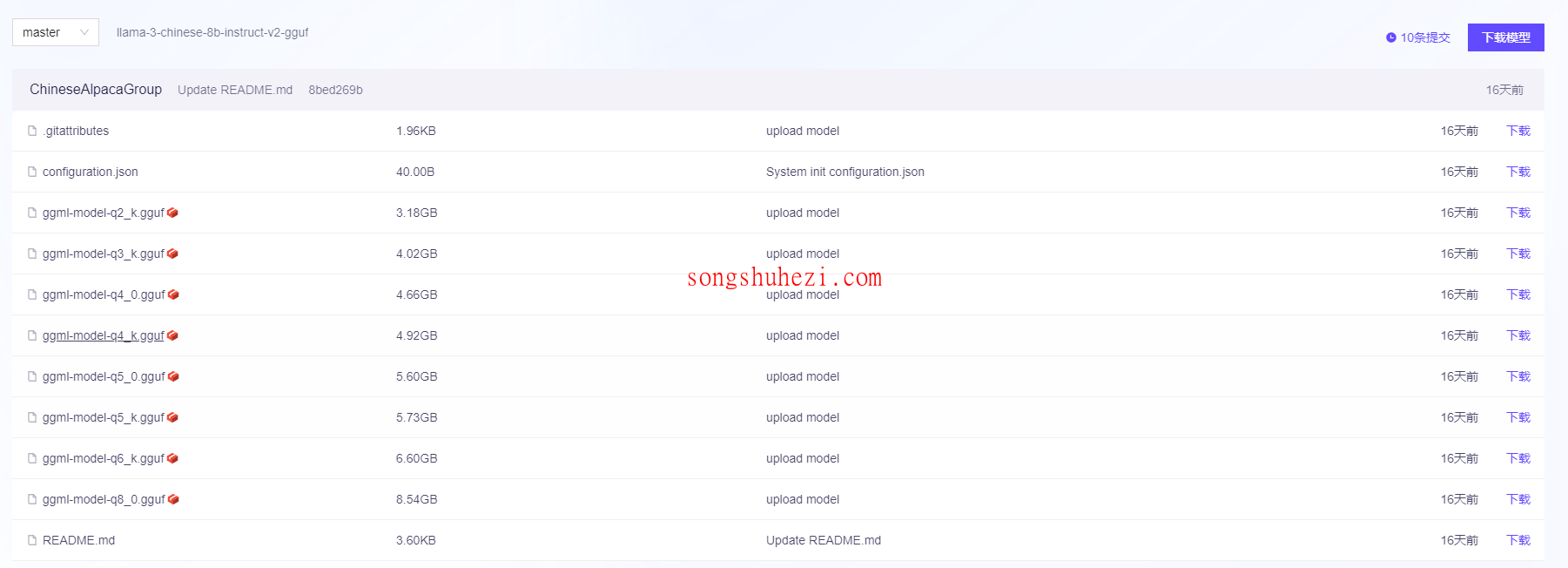

下载LLaMA3中文微调模型

我已经将需要的模型整理到网盘了,大家扫描文章开头的二维码下载就好了。

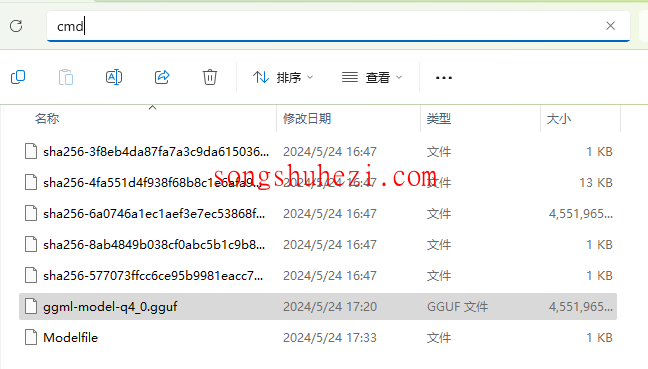

下载要使用的中文微调模型放到如下目录并创建 Modelfle:

Modelfle我也整理到网盘了,大家如果是按照这个教程部署,Modelfle完全可以不用改,大家扫描文章开头的二维码下载就好了。

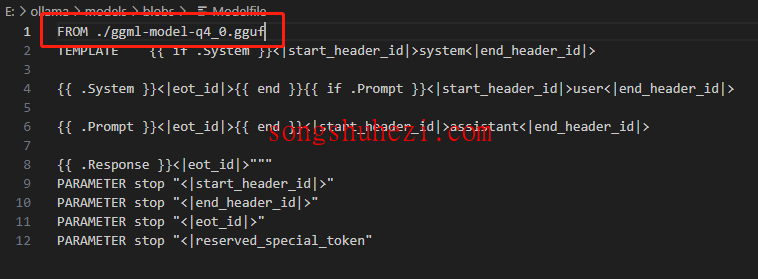

Modelfile 文件内容如下:

复制

FROM ./ggml-model-q4_0.gguf

TEMPLATE """{{ if .System }}<|start_header_id|>system<|end_header_id|> {{ .System }}<|eot_id|>{{ end }}{{ if .Prompt }}<|start_header_id|>user<|end_header_id|> {{ .Prompt }}<|eot_id|>{{ end }}<|start_header_id|>assistant<|end_header_id|> {{ .Response }}<|eot_id|>"""

PARAMETER stop "<|start_header_id|>"

PARAMETER stop "<|end_header_id|>"

PARAMETER stop "<|eot_id|>"

PARAMETER stop "<|reserved_special_token"

FROM ./ggml-model-q4_0.gguf TEMPLATE “””{{ if .System }}<|start_header_id|>system<|end_header_id|> {{ .System }}<|eot_id|>{{ end }}{{ if .Prompt }}<|start_header_id|>user<|end_header_id|> {{ .Prompt }}<|eot_id|>{{ end }}<|start_header_id|>assistant<|end_header_id|> {{ .Response }}<|eot_id|>””” PARAMETER stop “<|start_header_id|>” PARAMETER stop “<|end_header_id|>” PARAMETER stop “<|eot_id|>” PARAMETER stop “<|reserved_special_token”

复制

FROM 字段指向GGUF文件的路径,本次主要是知识库问答系统,术语聊天交互,这里使用的是Instruct模型

TEMPLATE 字段定义了Llama-3-Instruct的指令模板格式

SYSTEM 字段定义了系统指令(目前设置为空)

PARAMETER 字段定义了一些超参数,详细列表参见:https://github.com/ollama/ollama/blob/main/docs/modelfile.md

FROM 字段指向GGUF文件的路径,本次主要是知识库问答系统,术语聊天交互,这里使用的是Instruct模型 TEMPLATE 字段定义了Llama-3-Instruct的指令模板格式 SYSTEM 字段定义了系统指令(目前设置为空) PARAMETER 字段定义了一些超参数,详细列表参见:https://github.com/ollama/ollama/blob/main/docs/modelfile.md

安装LLaMA3中文微调模型

在当前目录下,打开终端命令。

执行通过 Modelfile 创建模型的命令创建中文微调 llama3 模型:

复制

ollama create llama3-Chinese:8B -f Modelfile

ollama create llama3-Chinese:8B -f Modelfile

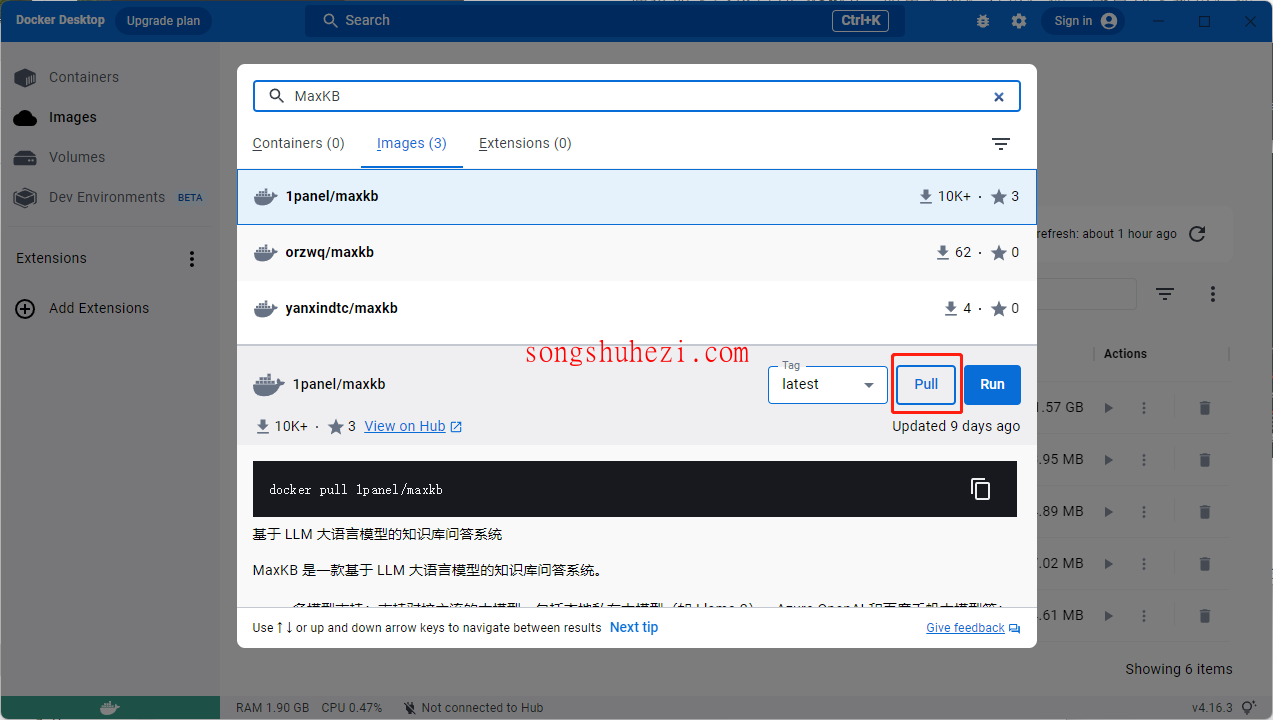

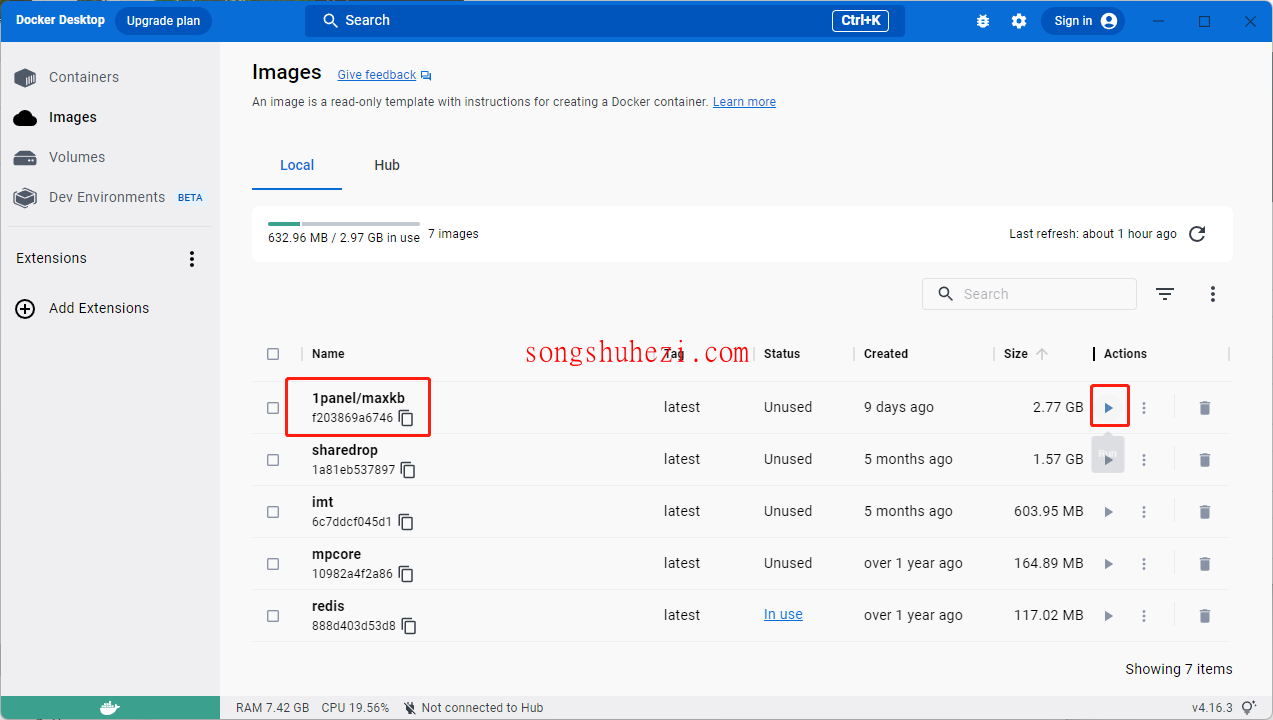

三、安装MaxKB

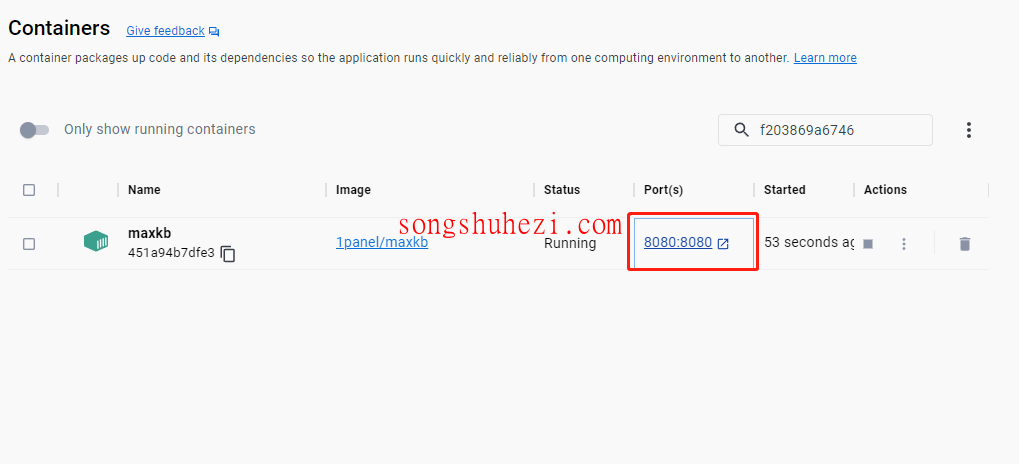

确保电脑上安装了Docker,然后通过Docker安装MaxKB。

然后运行maxkb

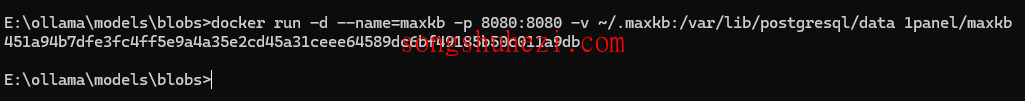

或者使用命令安装并运行启动MaxKB服务。

复制

docker run -d --name=maxkb -p 8080:8080 -v ~/.maxkb:/var/lib/postgresql/data 1panel/maxkb

docker run -d –name=maxkb -p 8080:8080 -v ~/.maxkb:/var/lib/postgresql/data 1panel/maxkb

然后回到docker打开部署页面或打开浏览器输入http://localhost:8080/。

四、登录MaxKB并配置LLaMA3模型

登录MaxKB

第一次登录MaxKB,需要默认用户名和密码。

复制

# 用户名: admin

# 密码: MaxKB@123..

# 用户名: admin # 密码: MaxKB@123..

然后按照提示修改密码。

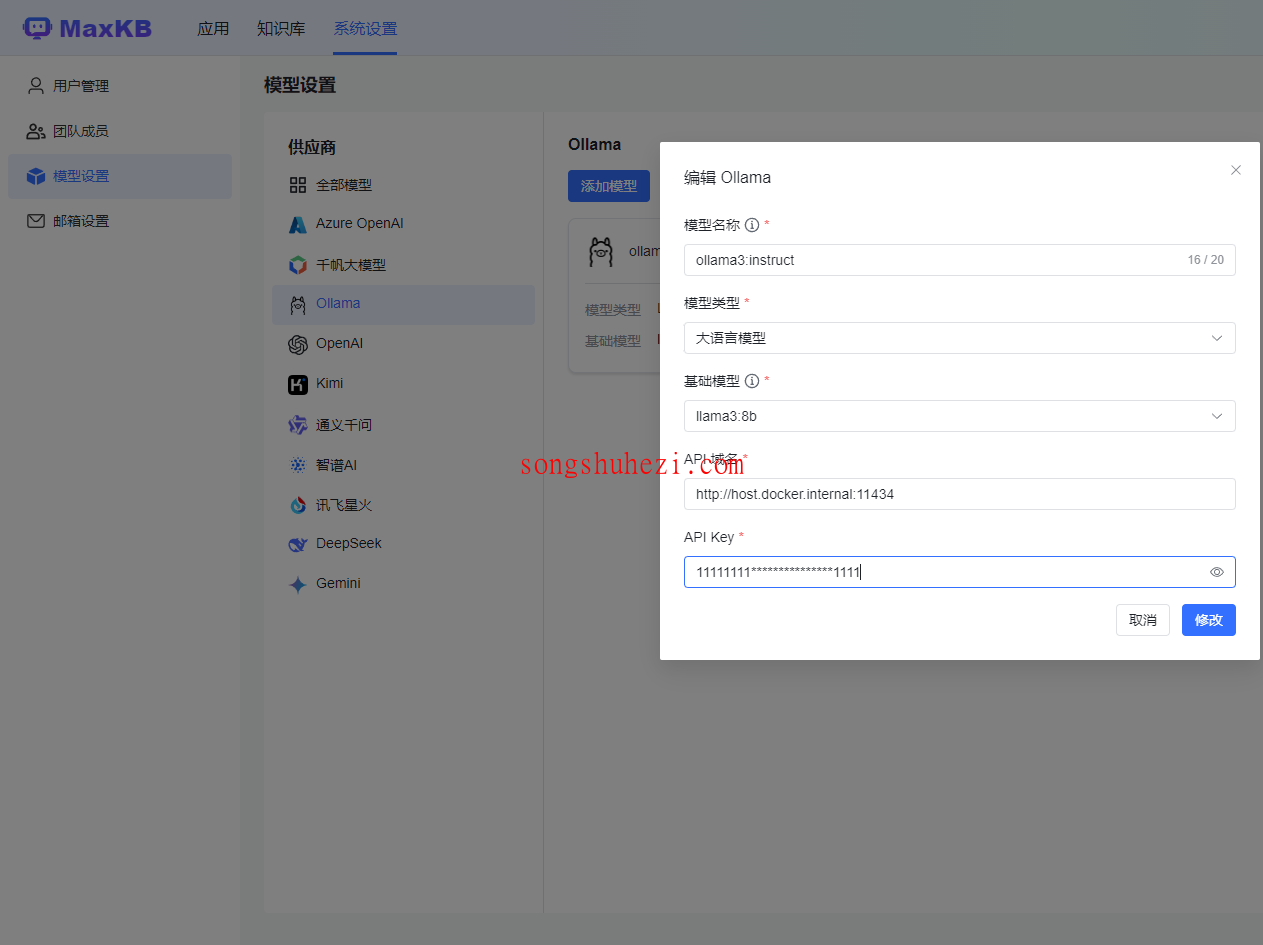

配置本地的LLaMA3中文微调模型服务

进入系统配置>模型设置>Ollama添加模型。

如果你也是使用 Docker 安装的 MaxKB,API 域名参考这个地址。

复制

http://host.dockerinternal:11434

http://host.dockerinternal:11434

如果没有 API Key 可以输入任意字符。点击【添加】后 校验通过则添加成功,便可以在应用的 AI 模型列表选择该模型。

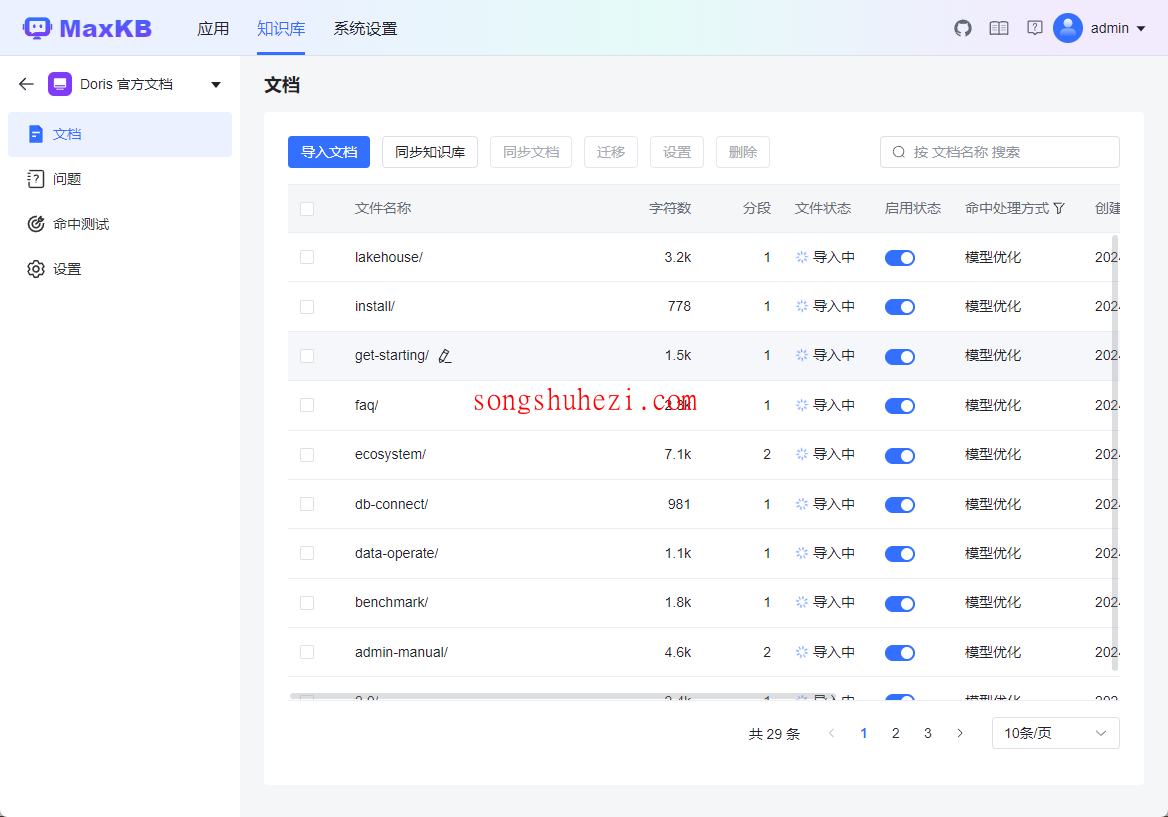

五、创建知识库

可以看到这里支持两种创建知识库的方式:

1、通用型,支持线下导入文件格式(目前支持txt, markdown,pdf, docx 等类型文档)

2、Web 站点导入,通过网站链接根目录导入。

知识库同步界面如下,可以等待同步完成再进入后续操作:

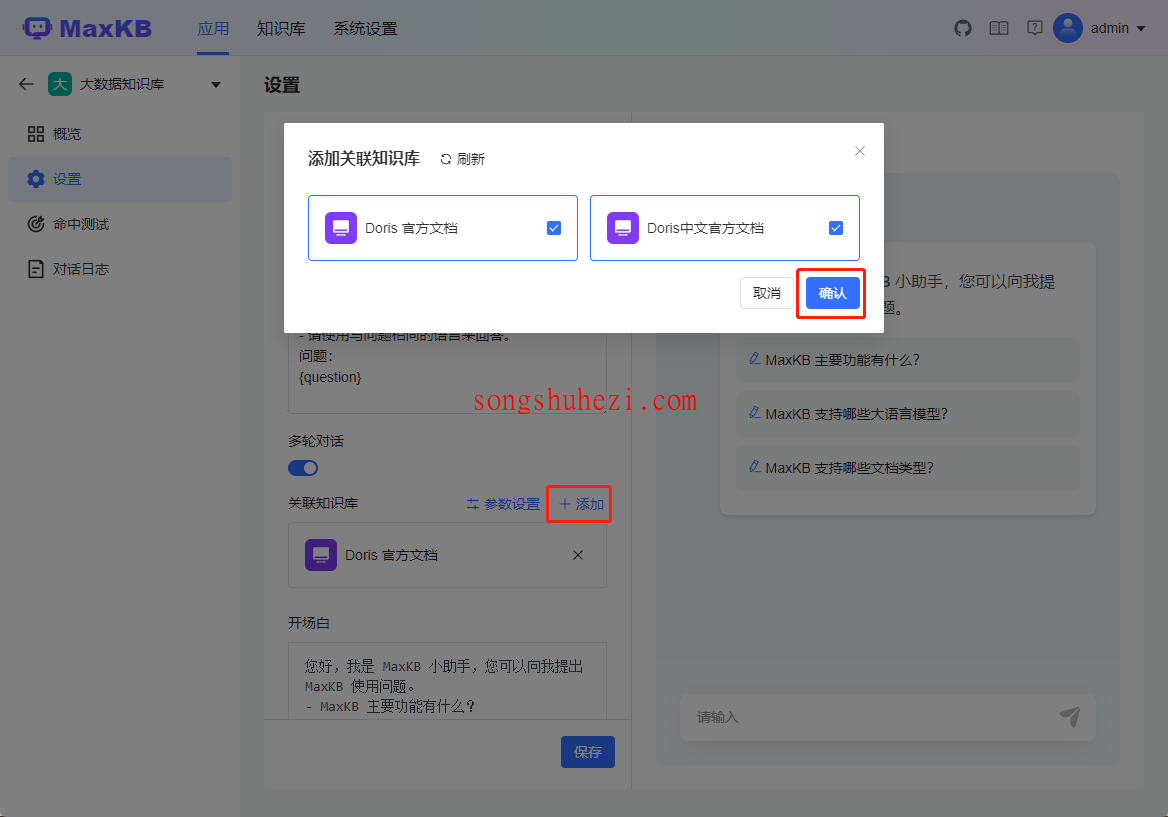

六、创建 MaxKB 应用

进入应用>创建应用配置应用。

关联现有数据库。

七、使用 MaxKB 应用

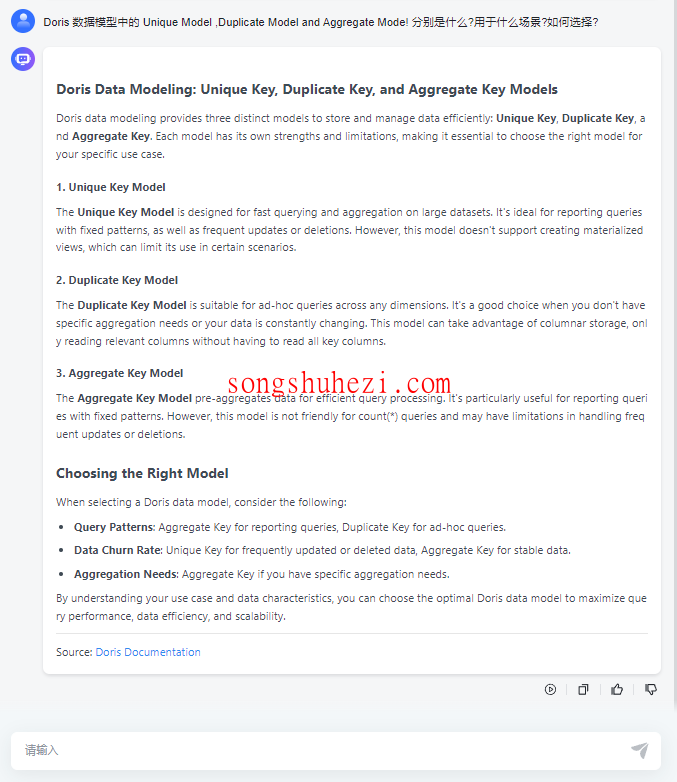

我们问它一个 Doris 的问题,看看效果。

可以看到它的来源是Doris的文档,说明我们已经创建成功了。

阅读全文

温馨提示: