Groq是什么?

Groq是一家美国AI芯片公司,专注于设计和制造高性能、高能效的AI处理器。

最近,Groq公司推出了一个免费的在线大模型推理服务,借助于自研的AI芯片LPU,每秒能够输出近 500 个 token。相比之下,ChatGPT-3.5 每秒生成速度仅为 40 个 token。

Groq并没有研发新模型,它是一个模型启动器,推理服务部署的是开源模型Mixtral 8x7B-32k和Llama 270B-4k。

有网友将其与 GPT-4、Gemini 对标,看看它们完成一个简单代码调试问题所需的时间。没想到,Groq 完全碾压两者,在输出速度上比 Gemini 快 10 倍,比 GPT-4 快 18 倍。

如何使用Groq?

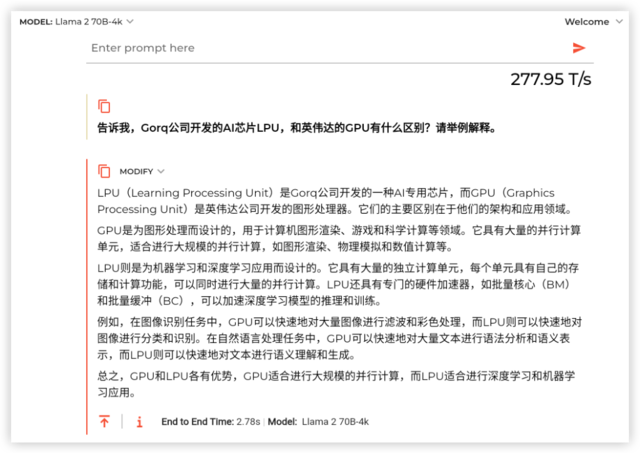

AIHub体验了一下,推理回复速度确实非常快,1000字的内容,眨眼之间完成。

不需要注册账号,任何人都可以免费使用。

Groq体验地址:https://groq.com/

Groq 使用界面

Groq 使用界面

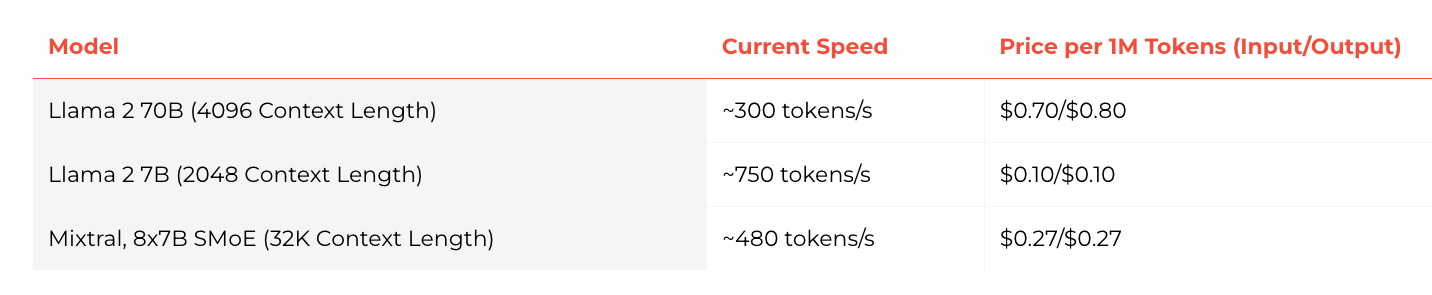

对于开发者,Groq 也提供了 API 服务,完全兼容 OpenAI API。

Mixtral 8x7B SMoE 可以达到 480 token / S,100 万 token 价格为 0.27 美元。极限情况下,用 Llama2 7B 甚至能实现 750 token / S。

Groq API服务价格

Groq API服务价格

关于Groq LPU芯片

根据Groq官网介绍,LPU是一种专为AI推理所设计的芯片。驱动包括GPT等主流大模型的GPU,是一种为图形渲染而设计的并行处理器,有数百个内核,而LPU架构则与GPU使用的SIMD(单指令,多数据)不同,这种设计可以让芯片更有效地利用每个时钟周期,确保一致的延迟和吞吐量,也降低了复杂调度硬件的需求。